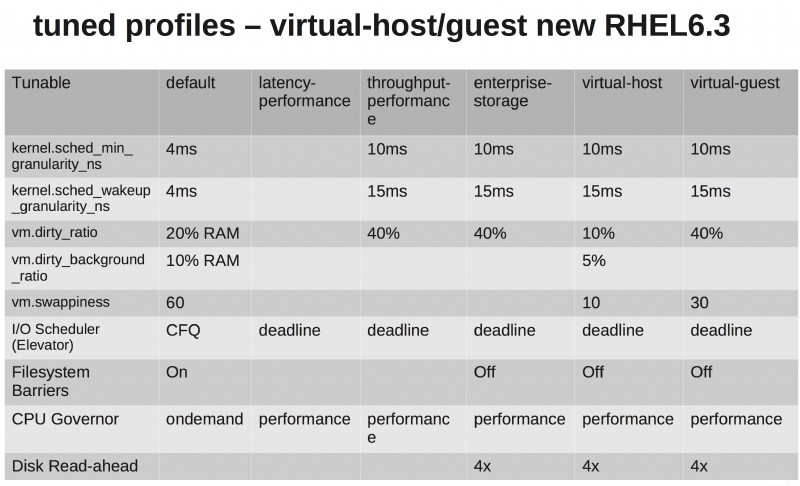

Ecco il programma delle configurazioni di tuned-adm...

Penso che sia utile vederli in forma tabellare. La cosa principale da notare è che le impostazioni predefinite di RHEL6 fanno schifo!! L'altra cosa è che i profili enterprise-storage e virtual-guest sono identici tranne che per una minore swappiness sul lato ospite virtuale (ha senso, vero?).

Per quanto riguarda una raccomandazione sull'ascensore I/O di archiviazione, hai alcuni livelli di astrazione sul livello di archiviazione. L'utilizzo dello scheduler noop avrebbe senso se si utilizzassero RDM o si presentasse l'archiviazione direttamente alle macchine virtuali. Ma dal momento che vivranno su NFS o VMFS, mi piacciono ancora le opzioni di ottimizzazione aggiuntive offerte dallo scheduler delle scadenze.

I profili ottimizzati possono essere modificati al volo sui sistemi in esecuzione, quindi se hai dubbi, prova con la tua applicazione, l'ambiente specifico e il benchmark.

Dai un'occhiata ai video di ottimizzazione delle prestazioni di Shak e Larry da Summit, parlano in dettaglio dei profili ottimizzati.

- Parte 1 - http://www.youtube.com/watch?v=fATEiBJ3pKw

- Parte 2 - http://www.youtube.com/watch?v=km-vLELmWLs

Uno degli aspetti più importanti è che i profili sono solo un punto di partenza consigliato, non numeri immutabili che sono magicamente perfetti per ogni ambiente.

Inizia con un profilo e gioca con le impostazioni. Genera un buon carico di lavoro di test simile alla produzione e misura le metriche importanti per la tua azienda.

Cambia una cosa alla volta e registra ogni risultato ad ogni iterazione. Quando hai finito, rivedi i risultati e scegli le impostazioni che hanno dato i migliori risultati. Questo è il tuo profilo sintonizzato ideale.

La risposta breve è che qualsiasi messa a punto è un'ipotesi e ha valore solo se supportata da dati empirici:provalo. Misuralo. Se non ti piace, modificalo.

Una risposta più lunga:

L'aumento di dirty_ratio significherebbe probabilmente prestazioni di scrittura più elevate ... IO verrà bloccato per un tempo considerevolmente più lungo

No. L'aumento del rapporto sporco significa che è meno probabile che il tuo sistema entri in uno stato in cui deve iniziare a bloccare le scritture. Lo svantaggio è che c'è più memoria utilizzata e un maggior rischio di perdita di dati in caso di interruzione.

ciò significa che le attività in esecuzione avranno più tempo per completare il proprio lavoro

I processi di solito cederanno prima della scadenza del loro intervallo di tempo. Il problema con una VM è che la tua macchina potrebbe competere per CPU e cache L1/L2 con altre VM:alti livelli di cambio di attività (a causa della prelazione) hanno un grande impatto sul throughput. Il tipo di applicazioni che vengono solitamente distribuite nelle VM sono quelle che sono legate alla CPU (server web, server delle applicazioni).

Sì, l'aumento della velocità effettiva (che si applica a tutti i tipi di applicazione) avverrà al costo di un aumento della latenza, ma quest'ultima è dell'ordine dei microsecondi quando la maggior parte delle transazioni richiede millisecondi. Se hai bisogno di funzionalità in tempo reale/latenza molto bassa, non dovresti utilizzare una VM.