In questo tutorial, ti mostreremo come installare Apache Spark su Debian 11. Per quelli di voi che non lo sapessero, Apache Spark è un programma gratuito, open source e generico framework per l'elaborazione in cluster. È appositamente progettato per la velocità e viene utilizzato nell'apprendimento automatico per eseguire lo streaming di elaborazione in query SQL complesse. Supporta diverse API per lo streaming, l'elaborazione di grafici tra cui Java, Python, Scala e R. Spark è principalmente installato in cluster Hadoop ma puoi anche installare e configurare spark in modalità standalone.

Questo articolo presuppone che tu abbia almeno una conoscenza di base di Linux, sappia come usare la shell e, soprattutto, che ospiti il tuo sito sul tuo VPS. L'installazione è abbastanza semplice e presuppone che tu sono in esecuzione nell'account root, in caso contrario potrebbe essere necessario aggiungere 'sudo ' ai comandi per ottenere i privilegi di root. Ti mostrerò l'installazione passo passo di Apache Spark su una Debian 11 (Bullseye).

Prerequisiti

- Un server che esegue uno dei seguenti sistemi operativi:Debian 11 (Bullseye).

- Si consiglia di utilizzare una nuova installazione del sistema operativo per prevenire potenziali problemi.

- Un

non-root sudo usero accedere all'root user. Ti consigliamo di agire comenon-root sudo user, tuttavia, poiché puoi danneggiare il tuo sistema se non stai attento quando agisci come root.

Installa Apache Spark su Debian 11 Bullseye

Passaggio 1. Prima di installare qualsiasi software, è importante assicurarsi che il sistema sia aggiornato eseguendo il seguente apt comandi nel terminale:

sudo apt update sudo apt upgrade

Passaggio 2. Installazione di Java.

Esegui il seguente comando di seguito per installare Java e altre dipendenze:

sudo apt install default-jdk scala git

Verifica l'installazione di Java usando il comando:

java --version

Passaggio 3. Installazione di Apache Spark su Debian 11.

Ora scarichiamo l'ultima versione di Apache Spark dalla pagina ufficiale usando wget comando:

wget https://dlcdn.apache.org/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

Successivamente, estrai il file scaricato:

tar -xvzf spark-3.1.2-bin-hadoop3.2.tgz mv spark-3.1.2-bin-hadoop3.2/ /opt/spark

Dopodiché, modifica il ~/.bashrc file e aggiungi la variabile di percorso Spark:

nano ~/.bashrc

Aggiungi la seguente riga:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Salva e chiudi il file, quindi attiva la variabile di ambiente Spark utilizzando il seguente comando:

source ~/.bashrc

Passaggio 3. Avvia Apache Spark Master Server.

A questo punto Apache spark è installato. Ora avviamo il suo server master autonomo eseguendo il suo script:

start-master.sh

Per impostazione predefinita, Apache Spark è in ascolto sulla porta 8080. Puoi verificarlo con il seguente comando:

ss -tunelp | grep 8080

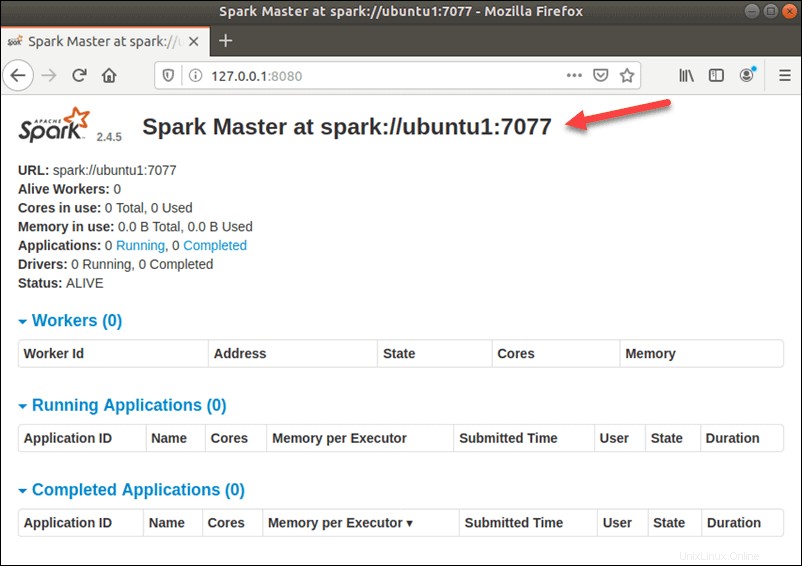

Passaggio 4. Accesso all'interfaccia Web di Apache Spark.

Una volta configurato correttamente, ora accedi all'interfaccia web di Apache Spark utilizzando l'URL http://your-server-ip-address:8080 . Dovresti vedere il servizio master e slave Apache Spark nella schermata seguente:

In questa configurazione standalone a server singolo, avvieremo un server slave insieme al server master. Il start-slave.sh il comando viene utilizzato per avviare Spark Worker Process:

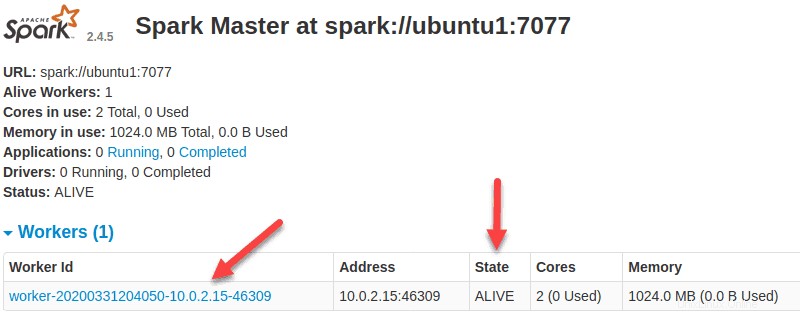

start-slave.sh spark://ubuntu1:7077

Ora che un lavoratore è attivo e funzionante, se ricarichi l'interfaccia utente Web di Spark Master, dovresti vederlo nell'elenco:

Una volta terminata la configurazione, avvia il server master e slave, verifica se la shell Spark funziona:

spark-shell

Otterrai la seguente interfaccia:

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 3.1.2

/_/

Using Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.12)

Type in expressions to have them evaluated.

Type :help for more information.

scala> Congratulazioni! Hai installato con successo Apache Spark. Grazie per aver utilizzato questo tutorial per installare l'ultima versione di Apache Spark su Debian 11 Bullseye. Per ulteriore aiuto o informazioni utili, ti consigliamo di controllare il Sito Web Apache Spark.