Il mio comando magico in una situazione del genere è :

du -m . --max-depth=1 | sort -nr | head -20

Per usare questo :

cdnella directory di livello superiore contenente i file che consumano spazio. Può essere/se non ne hai idea;-)- esegui

du -m . --max-depth=1 | sort -nr | head -20. Questo elencherà le 20 sottodirectory più grandi della directory corrente, ordinate per dimensione decrescente. cdnella directory più grande e ripetidu ...comando finché non trovi i file BIG

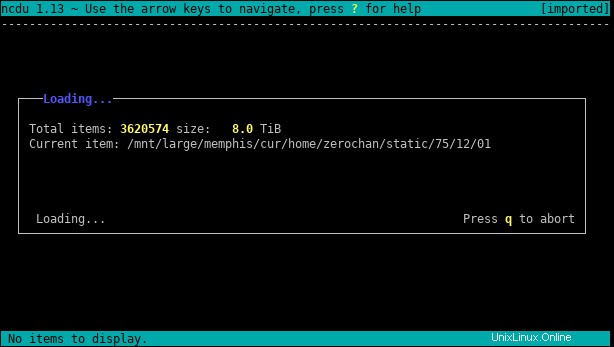

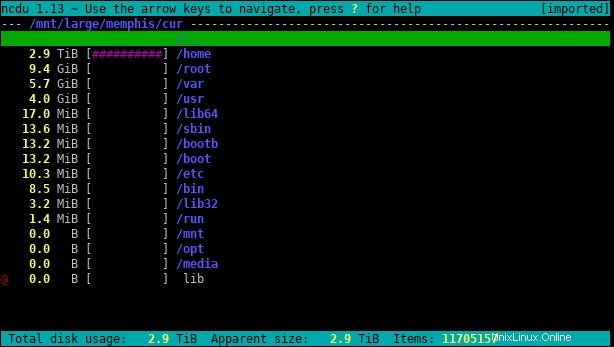

ncdu è un ottimo strumento per questo tipo di problema. Ecco il pacchetto corrispondente.

Puoi usare -x se vuoi rimanere su un solo filesystem, senza seguire i collegamenti simbolici. Ad esempio, come root:

ncdu -x /home

È l'equivalente a riga di comando di DaisyDisk, Baobab o WinDirStat.

La scansione di cartelle di grandi dimensioni potrebbe richiedere molto tempo, ma una volta completata dovrebbe essere molto veloce trovare i file più grandi.

Se hai un'idea della dimensione effettiva del file puoi find file più grandi di una dimensione specifica.

Ad esempio, per trovare file più grandi di 10 MiB:

find /mounted/drive -size +10M

Oppure

find /mounted/drive -size +10M -exec ls -lh {} +

Il suggerimento di Httqm è valido anche se il problema non è un file di grandi dimensioni ma una vasta raccolta di file più piccoli. Questo è usare du per mostrare i totali della directory. Limitazione con --max-depth è molto utile con alberi di directory di grandi dimensioni:

du -m some/directory --max-depth=1 | sort -nr | head -20

du some/directory --max-depth=1 | sort -n | tail -21

Suddividerà una singola directory in sottodirectory, la seconda di queste ti darà anche il totale per la directory che stai elencando.